PC性能の調べ方

自分のPCがどれだけの性能かを知りたくありませんか?今回は、TOPS(Tera Operations Per Second)に着目したいと思います。

PC(特にCPUやGPU)がどれくらいの TOPSを持っているかを調べる方法はいくつかあります。

🔍 1. TOPSとは何か

TOPS は、1秒間に処理できる「演算回数(Tera operations per second)」を表す性能指標で、主にAI推論やディープラーニング処理などの性能を測る際に使われます。

1 TOPS = 1兆回の演算/秒

通常、GPUやNPU(AIアクセラレータ)でよく使われます。

💻 2. 自分のPCのハードウェアを確認する

● CPU/GPU の型番を確認

まずは型番を調べます。

○ Windowsの場合

Windowsキー + R → 「dxdiag」と入力 → Enter

→ 「ディスプレイ」タブでGPU、「システム」タブでCPUを確認

または

タスクマネージャー → 「パフォーマンス」タブで確認

○ macOSの場合

「Appleメニュー」 → 「このMacについて」

→ CPU/GPUの情報が表示されます。

○ Linuxの場合

lscpu

lspci | grep -i nvidia

⚙️ 3. CPU・GPUのTOPS値を調べる

型番が分かったら、その型番名を使ってWeb検索します:

たとえば:

「Apple M2 TOPS」 → 約15.8 TOPS(Neural Engine)

「NVIDIA RTX 4090 TOPS」 → 約1300 TOPS(FP8推論時)

「Intel Core Ultra 7 155H NPU TOPS」 → 約11 TOPS(AI推論性能)

🧠 メーカーの公式資料・ホワイトペーパー・製品ページなどに「AI performance」や「INT8 TOPS」「FP16 TFLOPS」などの記載があります。

🧩 4. 実測したい場合(ベンチマーク)

実際のTOPS性能を近似的に測りたい場合、以下のツールを使います。

○ Windows

Geekbench ML:CPU/GPU/NPUごとのAI性能を測定。

AI Benchmark:TensorFlowを使ったAI処理テスト。

○ macOS / iOS

Appleの開発者ツール「Core ML Benchmark」など。

○ Linux

phoronix-test-suite

TensorRTやONNX Runtimeのベンチマークスクリプト。

📈 5. TOPSを推定する簡易計算(理論値)

理論上のTOPSを概算したい場合:TOPS ≈ クロック周波数(Hz) × 演算ユニット数 × 1クロックあたり演算数 ÷ 10^12

たとえば:1GHz × 1000演算ユニット × 2演算/クロック = 2 TOPS(理論値)

私は自分のPCのGPUの型番:NVIDIA GeForce RTX 3060 からChatGPTに調べてもらいました。

NVIDIA GeForce RTX 3060 は、ミドルハイレンジのGPUで、AI推論や機械学習タスクにも十分使える性能を持っています。

以下に、TOPS(および関連するAI演算性能)の詳細を整理します👇

⚙️ NVIDIA GeForce RTX 3060 の基本スペック

| 項目 | 内容 |

| ————– | ————- |

| GPUアーキテクチャ | Ampere(GA106) |

| CUDAコア数 | 3584 |

| Tensorコア(第3世代) | 約112基 |

| ベースクロック | 約1.32 GHz |

| ブーストクロック | 約1.78 GHz |

| FP32理論性能 | 約13 TFLOPS |

| メモリ | 12GB GDDR6 |

| 消費電力 | 約170W |

※RTX 3060はAI演算を加速するTensorコアを備えています。

※CUDA(Compute Unified Device Architecture)は、NVIDIA GPUの並列処理機能を活かすための技術であり、AI処理の高速化を支えています。

💡補足:CUDA(クーダ)は、NVIDIAが開発したGPU向けの計算プラットフォームで、AIや画像生成などの高速処理を実現するための中核技術です。PyTorchやTensorFlowなどのAIフレームワークもCUDAを通じてGPUの性能を引き出しています。

🤖 AI処理性能(TOPS換算)

Ampere世代のTensorコアは、INT8やFP16などの低精度演算を高速に処理できるよう最適化されています。

以下は推定値(理論値)です:

| 演算精度 | 理論性能 | 備考 |

| ———— | ——————– | ——————- |

| FP32(単精度) | 約13 TFLOPS | 一般的な浮動小数点演算性能 |

| FP16(半精度) | 約26 TFLOPS ≒ 26 TOPS | AIトレーニング・推論でも利用可 |

| INT8(整数8ビット) | 約52 TOPS | 多くのAI推論エンジンがこの精度を使用 |

| INT4(整数4ビット) | 約104 TOPS | 量子化推論などで理論上到達可能 |

🧠 つまり、RTX 3060 の「AI推論性能」は 約50〜100 TOPS の範囲と考えられます(INT8換算で約52 TOPS前後が一般的な指標です)。

📊 参考値(比較)

| GPU | INT8 TOPS(おおよそ) | 世代 |

| ———— | —————– | ———— |

| RTX 2060 | 約25 TOPS | Turing |

| RTX 3060 | 約52 TOPS | Ampere |

| RTX 4070 | 約82 TOPS | Ada Lovelace |

| RTX 4090 | 約1300 TOPS(FP8換算) | Ada Lovelace |

✅ まとめ

RTX 3060 のAI性能は約52 TOPS(INT8)前後

FP16演算で約26 TOPS、FP32で約13 TFLOPS(≒13 TOPS)

最新世代GPUよりは劣るが、十分に強力なAI推論用GPU

PCの性能の活かし方

52topsのAI性能を自分のPCでどうやって使えば良いのでしょうか。

「RTX 3060 が 52 TOPS のAI性能を持っている」と聞いても、実際にどう使うのかは少し分かりにくいです。

💡 RTX 3060 の「AI性能(Tensorコア)」は、AI推論や学習を行うソフトウェアやライブラリを通して自動的に利用されます。

つまり、私が直接「TOPSを呼び出す」わけではなく、

それを活かす「ツール」や「フレームワーク」を使うことでその性能を引き出せます。

🧠 1. 「52 TOPS」を直接使うことはできない理由

TOPSはハードウェアの理論性能指標であって、ユーザーが「TOPSを実行する」ような命令は存在しません。

たとえば:

○ AI画像生成(Stable Diffusion) や

○ 大規模言語モデル(LLM)の推論、

○ 機械学習モデルのトレーニング(PyTorch / TensorFlow)

を実行すると、その裏で Tensorコア(AI専用演算ユニット) が使われ、結果的にTOPSに近い処理性能が発揮されます。

※PyTorchやTensorFlowなどのAIフレームワークは、内部的にCUDAを利用してGPUの計算力を引き出します。

💬ここでいうCUDAとは、GPUの演算機能をAI処理で使えるようにするための“橋渡し技術”です。

ユーザーが特別な操作をしなくても、AIフレームワークが自動的にCUDA経由でGPUを活用します。

🧰 2. セットアップの基本手順(Windows想定)

1. NVIDIAドライバを最新化(公式サイト)

2. CUDA Toolkit をインストール(NVIDIA CUDA Toolkit)

3. cuDNN をインストール(cuDNN)

4. AIライブラリ(PyTorch / TensorFlowなど)をCUDA対応版でインストール

目的によって、その用途に合った活かし方とセットアップ手順がある。

主な目的の例:「画像生成」「動画AI」「音声認識」「LLM(チャットAI)推論」など

私のPCの用途は…

LLM(Large Language Model, 大規模言語モデル)をローカルで使いたい。=「LLMを自分のPCで動かす」

ChatGPTに頼っているような「会話」「文章理解」「情報整理」「思考支援」などを代わりに実行するAIモデルは、LLM と呼ばれるものです。

🧠 1. LLM(大規模言語モデル)とは?

LLM(Large Language Model) は、

膨大なテキストデータを学習して、自然な言語を理解・生成できるAI のことです。

たとえば、今、しているような質問に対して:

○ 文脈を理解し、

○ 推論を行い、

○ 自然な文章で答える

という一連のプロセスを実現するのがLLMです。

💬 2. ChatGPTのようなAIはすべてLLMベース

ChatGPTも、Claudeも、Geminiも、すべて根っこはLLMです。

| サービス名 | ベースモデル |

| —————– | ————————— |

| ChatGPT | GPTシリーズ(OpenAI) |

| Claude | Claudeシリーズ(Anthropic) |

| Gemini | Geminiシリーズ(Google DeepMind) |

| Llama | Meta(オープンソース) |

| Mistral / Mixtral | Mistral AI(オープンソース) |

⚙️ 3. RTX 3060 で LLM を動かせるのか?

結論:✅ 動かせます(7Bクラス程度なら快適)

RTX 3060(12GB VRAM)なら、以下のようなLLMが現実的です:

モデル パラメータ数 動作例 備考

Llama 3 8B 約8B(80億) 可能 高品質、7〜15トークン/秒程度

Mistral 7B 約7B 快適 小型・高精度

Phi-3 mini (3.8B) 約3.8B 余裕 低VRAM向け

Gemma 2 7B 約7B 快適 Google製の軽量モデル

⚡ これらをローカルで動かすと、ChatGPT のような会話や要約をネットに接続せずに実行できます。

🧩 4. LLMをローカルで動かす主な方法

① Ollama(最も簡単)

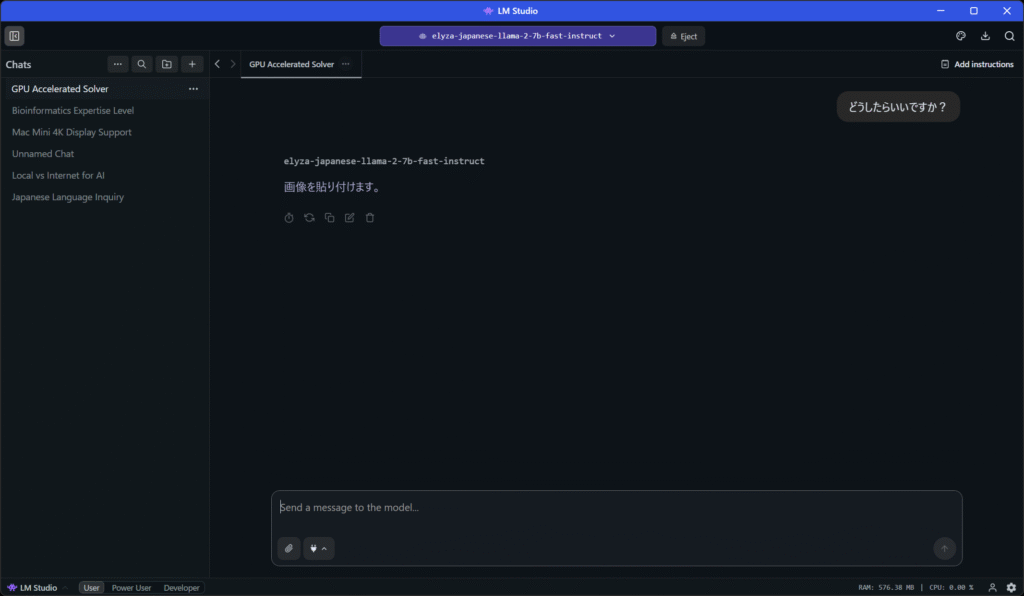

② LM Studio(GUI派におすすめ)

③ 手動でPythonから動かす(上級者)

があるのですが、私は②を選びました。

🧱 LM Studio(GUI派におすすめ)

https://lmstudio.ai

Ollamaと同じ仕組みで、GUI操作が可能。

モデルを選んでクリック1つで起動できます。

GPT風のチャットUIも内蔵。

🚀 5. LLMをRTX 3060で動かすときのポイント

○ VRAM容量が重要(12GBあれば7BモデルOK、13Bは難しい)

○ 量子化(Quantization)を使うと軽くできる

例:q4_K_M や gguf 形式で軽量化

○ GPUドライバ & CUDA Toolkit を最新版にしておく

○ 推論エンジン(TensorRT-LLM, vLLM)を使うと高速化可能

🧩 6. まとめ

| 項目 | 内容 |

| ——————– | —————————— |

| 私が今使っているChatGPTの正体 | LLM(大規模言語モデル) |

| RTX 3060で動かせるか | ✅ はい(7Bクラスまで快適) |

| 準備に必要なもの | CUDA, ドライバ, OllamaまたはLM Studio |

| メリット | オフライン動作、低遅延、プライバシー確保 |

| デメリット | 最新知識やWeb検索は別途実装が必要 |

CUDA Toolkitを最新に更新する手順

✅ 1. 現在のCUDAバージョンを確認する

🪟 Windowsの場合

① スタートメニューで「コマンドプロンプト」を開く

② 次のコマンドを入力:

nvidia-smi

出力される表の右上に、CUDA Version: が表示されます。

🌐 2. NVIDIA公式サイトから最新版を確認・ダウンロード

公式サイト:

🔗 https://developer.nvidia.com/cuda-downloads

ページでの操作:

Operating System → 「Windows」

Architecture → 「x86_64」

Version → 「10」または「11」など、あなたのWindowsに合わせる

Installer Type → 通常は「exe (network)」を選択

「Download」をクリック

🧩 3. インストール手順

ダウンロードした .exe を実行して、以下のように進めます。

1. インストーラーが起動

→ 「Custom(カスタム)」を選択して次へ進むと、古いCUDAの削除も同時に行えます。

2. 古いバージョンがある場合は上書きインストール

→ 自動的に上書きされます。再起動が必要な場合もあります。

3. 完了したら再起動

→ 再起動後、環境変数が反映されます。

🧮 4. 正常に更新されたか確認

再びコマンドプロンプトを開いて:

nvidia-smi

出力される表の右上に、CUDA Version: が表示されます。

💡補足:CUDA(クーダ)は、NVIDIAが開発したGPU計算プラットフォームで、AI推論・学習・画像生成などの高速処理を支える重要な技術です。

本文中で登場したPyTorchやTensorFlowなどのAIソフトウェアは、内部的にCUDAを通じてGPUを制御し、その性能を最大限に引き出しています。

LM Studioのインストール方法

※ここからはローカルでLLMを使ってみたい人向けの内容となります。

実際にローカルでLLMを使う方法を紹介します。

私が実際に使った感想として、個人情報をローカル内だけでとどめて使いたい人には向いているかと思いますが、ネットにつないで有料の ChatGPT5 を使った方がストレスがないと思いました。

インストールしただけでは、設定変更や画像の生成、アップロード、ダウンロードもできません。

💡 LM Studio(Local Model Studio)インストール手順【Windows版】

🧩 前提条件

OS:Windows 10 または 11(64bit)

空き容量:数GB(モデルをダウンロードする場合、さらに10GB以上推奨)

GPUがある場合は、NVIDIAドライバおよびCUDAがインストール済みであると高速になります(なくてもCPU動作可)

🪜 手順

① インストーラの入手

LM Studioの公式サイト(またはGitHub)にアクセス

👉 https://lmstudio.ai/

「Download for Windows」をクリック。

LM-Studio-0.3.30-1-x64.exe がダウンロードされます。

② インストーラの実行

ダウンロードした LM-Studio-0.3.30-1-x64.exe をダブルクリック。

セキュリティ警告が出たら「はい」を選択。

インストールウィザードが開くので、以下を確認:

インストール先フォルダ(通常はデフォルトのままでOK)

「Install」ボタンをクリック。

数分でインストールが完了します。

③ 起動

スタートメニューまたはデスクトップに「LM Studio」が追加されるので起動します。

初回起動時に少し時間がかかる場合があります。

④ モデルのダウンロードと読み込み

起動後、「Model Browser」タブを開きます。

Hugging Face Hub のようなインターフェースが表示されるので、使用したいモデル(例:Llama-3, Mistral, Phi-3, など)を検索。

「Download」ボタンを押すとモデルがローカルに保存されます。

ダウンロード完了後、「Load」ボタンでモデルを読み込みます。

⑤ チャット開始

モデルがロードされると、「Chat」タブでAIとの会話が可能になります。

ローカル実行なので、ネット接続がなくても使えます(初回モデルダウンロード時のみネット必須)。

⑥ オプション設定(任意)

Settings タブから GPU/CPU選択、スレッド数、メモリ制限などを設定できます。

GPU搭載PCの場合は「Use GPU」にチェックを入れておくと高速です。

🧹 アンインストール(参考)

Windowsの「設定」→「アプリ」→「LM Studio」を選び「アンインストール」でOK。

LM Studioで日本語モデルを使う方法

LM Studioは「Hugging Face」にあるモデルをローカルで実行できます。

英語モデルが多いですが、日本語対応モデルもいくつかあります。

以下では代表的な日本語モデルと、導入~利用までの流れを紹介します。

🧩 ① 日本語対応モデルの例

LM Studioで動作確認されている日本語モデルの一部を紹介します:

| モデル名(LM Studioで検索) | 説明 | 推奨スペック |

| ———————————————– | ———————————— | ———————- |

| **ELYZA-japanese-Llama-2-7b** | Llama 2を日本語特化で調整したモデル。自然な日本語応答が得られる。 | GPU 12GB以上推奨(CPUでも動作可) |

| **cyberagent/open-calm-7b** | 日本語LLMの定番。安定して日本語処理ができる。 | GPU 8〜12GB |

| **rinna/japanese-gpt-neox-3.6b** | 3.6Bパラメータで軽量。CPUでも比較的動く。 | GPU不要でも可 |

| **elyza/ELYZA-japanese-Llama-3-8B-instruct** | 最新版。指示理解が優秀で、文章生成精度が高い。 | GPU 16GB以上推奨 |

| **stabilityai/japanese-stablelm-base-alpha-7b** | StableLMベースの日本語対応モデル。自由度が高い。 | GPU 12GB以上推奨 |

⚙️ ② モデルの導入手順(例:ELYZA Llama 2)

1. LM Studioを起動

→ 上部タブの「Model Browser」を開きます。

2. 検索欄に「elyza-japanese-llama-2」を入力

3. 検索結果に

elyza/ELYZA-japanese-Llama-2-7b

が出たら「Download」をクリック。

4. ダウンロード完了後、「Load」を押すとモデルが読み込まれます。

💬 ③ チャットで日本語テスト

「Chat」タブに切り替えます。

以下のように入力してみましょう:

こんにちは。あなたは日本語を理解できますか?

→ 正しく設定できていれば、自然な日本語で応答します。

🧠 ④ 会話スタイルの最適化(プロンプト例)

日本語モデルでも、英語的な指示文の構造を意識すると安定します。

例:インストラクション型プロンプト

あなたは日本語で丁寧に説明するアシスタントです。

質問:LM Studioで日本語モデルを使うにはどうすればよいですか?

例:翻訳タスク

次の英文を日本語に翻訳してください。

Text: The quick brown fox jumps over the lazy dog.

⚡ ⑤ GPU最適化(オプション)

GPUが搭載されている場合:

Settings → Performance

「Use GPU」をオン

Threads(スレッド数)を CPUコア数の半分程度に設定

これで応答速度が大幅に改善します。

🧩 ⑥ 他のおすすめ設定

| 項目 | 内容 |

| —————— | ————— |

| **Context length** | 4096以上(長文対応) |

| **Temperature** | 0.7〜1.0(創造性の調整) |

| **Top P** | 0.9(出力の多様性) |

🎯 ⑦ 軽量モデルでの日本語利用(GPUなしでもOK)

GPUを持たない場合は、次のような軽量モデルを試すと良いです。

| モデル名 | 特徴 |

| ———————————– | —————- |

| **rinna/japanese-gpt-neox-3.6b** | CPUで動作可。短文応答が速い。 |

| **elyza/ELYZA-japanese-Llama-2-3b** | 省メモリで動作しつつ高品質。 |

| **small-stablelm-ja** | 小規模でも日本語自然。 |

✅ まとめ

| 手順 | 内容 |

| — | ———————– |

| 1 | LM Studioを開く |

| 2 | Model Browserで日本語モデルを検索 |

| 3 | Download → Load |

| 4 | Chatタブで日本語会話開始 |

| 5 | 必要ならSettingsでGPUを有効化 |

ロードするモデルの選択

LM Studio にロードするのは、OpenAI’s gpt-oss 20B と ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S では、どちらがいいか。

2つのモデル、「OpenAI’s gpt-oss 20B」 と 「ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S」 は、目的によって向き・不向きがハッキリ分かれます。

以下に比較と、おすすめの使い分けをまとめます👇

⚖️ 比較:gpt-oss 20B vs ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S

| 特徴 | 🧠 OpenAI’s gpt-oss 20B | 🇯🇵 ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S |

| ——————– | ———————– | ————————————————— |

| **パラメータ規模** | 約20B(超大型) | 約7B(中型・圧縮版) |

| **主な言語** | 英語中心(日本語はやや苦手) | 日本語特化(自然な文体) |

| **日本語の理解力** | △(翻訳っぽい日本語) | ◎(ネイティブ自然) |

| **英語の理解力** | ◎ 非常に高い | ○ 一般的な理解力あり |

| **指示応答能力(Instruct)** | 高い(英語で特に優秀) | 高い(日本語チューニング済) |

| **メモリ消費** | 大(VRAM 16GB以上推奨) | 軽い(4bit量子化で8GBでも動作可) |

| **応答速度** | 遅め(GPU必須) | 速い(fast版の利点) |

| **創造的生成(物語・アイデア)** | 優秀(英語向け) | 安定(日本語でも破綻少ない) |

| **最適用途** | 英語研究・翻訳・大規模タスク | 日本語会話・要約・文章作成 |

💡 結論:どちらを選ぶべきか?

✅ 日本語中心で使うなら:

→ ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S 一択です。

理由:「instruct」タイプなので、質問応答・説明・要約が得意。

4bit量子化(q4_K_S)で軽く、GPUメモリにも優しい。

出力が自然で、文法エラーがほぼない。

✅ 英語文書の要約・技術英文理解などをしたいなら:

→ gpt-oss 20B を試す価値あり。

ただし注意点として:日本語では「翻訳調」で、ややぎこちない。

VRAM消費が大きいので、GPU 16GB以上でないと遅い。

LM StudioのUI応答がもっさりすることもあります。

💬 実用的なおすすめ運用法

| 使用場面 | 推奨モデル |

| ————– | ——————————– |

| 日本語会話/日本語ブログ生成 | ELYZA 7b fast instruct |

| 英語文書読解・翻訳 | gpt-oss 20B |

| 英語→日本語翻訳 | gpt-oss 20B(精度高い)+ ELYZAで自然文に再整形 |

| 長文日本語要約 | ELYZA 7b fast instruct |

| GPUが8GB以下 | ELYZA 7b fast instruct(軽量動作) |

🚀 もし迷うなら…

最初の常用モデルとしては

ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_S

をロードしておくのが最も快適です。

動作が軽く、日本語も綺麗で、チャットや文章作成に最適です。

必要に応じて英語用に gpt-oss 20B を切り替えましょう。

※上記はChatGPTの解釈です。

※私の使い方が悪いのかもしれませんが、私には gpt-oss 20B を常用した方が便利に思えました。

その他のGPU活用法

この記事では、PCをLLM(LM Studio)に使いました。

LM StudioのようにGPUを使ってAIモデルを動かす以外にも、GPUの性能を活かせる使い方はたくさんあります。

主要な分野をわかりやすくまとめて紹介します👇

| 分野 | 内容 | 主なソフト/フレームワーク例 |

| ———————- | ————————— | —————————————- |

| 🎨 **画像生成AI** | テキストから画像を生成。高性能GPUで高速描画。 | Stable Diffusion, ComfyUI, Automatic1111 |

| 🧠 **機械学習/深層学習** | 自作AIモデルの学習・推論。GPUで数十倍速い。 | PyTorch, TensorFlow, Keras |

| 🕹️ **ゲーム/3D制作** | GPUの本来の用途。リアルタイム描画や物理演算。 | Unreal Engine, Unity, Blender |

| 🎬 **動画編集・エンコード** | 4K動画の編集や書き出しをGPUで高速処理。 | DaVinci Resolve, Adobe Premiere Pro |

| 🔬 **科学技術計算/シミュレーション** | GPUを使って大規模計算を並列処理。 | CUDA, MATLAB, Numba, Simulink |

| 🧩 **エミュレーション・仮想化** | GPU直結で仮想マシンやエミュレータを加速。 | VMware, QEMU, WSL2 CUDA, Docker GPU |

| 📸 **画像認識/分析** | 写真や映像をAIで解析。GPUでリアルタイム処理可能。 | OpenCV, YOLOv8, MediaPipe |

| 🗣️ **音声認識・音声合成** | 音声入力やボイス生成をGPUで加速。 | Whisper, RVC, TTSモデル(e.g. Piper, VITS) |

🧭 初心者におすすめのGPU活用3選

1. Stable Diffusion WebUI (Automatic1111) → 「テキスト→画像」生成。絵を描かなくても作品が作れる。

2. Whisper + GPU → 音声を文字起こし。日本語会議録にも便利。

3. Blender + GPUレンダリング → 無料3Dソフト。GPUでリアルな映像を高速に出力。

この記事は以上です。

Views: 41